产品推荐HOT PRODUCTS

细心的产品设计

先进的生产设备

完善的售后服务

严格的管理体系

关于我们

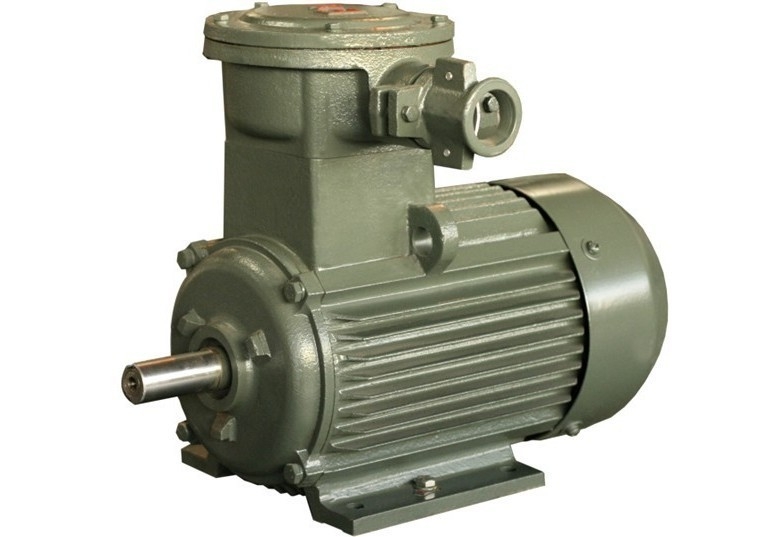

公司技术力量雄厚,拥有多位*的电动机和发bob全站app官方网站的设计、制造专家及一大批专业技术技术人员,经验丰富,技术精良;操作工人技术娴熟,操作专业。 公司制造设备精良,拥有先进的生产加工中心,制造工艺先进;拥有严格的质量管理体系,产品质量稳定可靠,通过了 ISO9001质量管理体系认证,产品曾为小浪底工程、泰山核电站等多项国家重点工程配套。尤其是在长轴深井泵bob全站app官方网站的生产和设计上,有着丰富的经验。已生产了1600KW,承受向下轴向力 25T的长轴深井泵bob全站app官方网站,产品为福耀玻璃公司、六盘水电站、贵州沟皮滩电站、云南昆明滇东电厂、贵州华电塘塞电厂等工程提供产品配套,目前运转良好。已成功开发了 KLB系列空心轴高压电...

MORE

我们的优势OUR STRENGTHS

产品应用多个领域,提供放心的产品和满意的服务

实力雄厚,品质保障

拥有多位*的电动机和发bob全站app官方网站的设计、制造专家及一大批专业技术技术人员

精良的生产设备

公司制造设备精良,拥有先进的生产加工中心,制造工艺先进,严格的质量管控,保障产品稳定可靠

众多客户案例,放心选择

通过了ISO9001质量管理体系认证,产品曾为小浪底工程、泰山核电站等多项国家重点工程配套

完善的售后服务,让您后顾无忧

专业客服一对一服务,7*24小时免费咨询热线,专业团队为用户安装调试并进行操作人员培训!

生产实力PRODUCTION STRENGTH

公司制造设备精良,拥有先进的生产加工中心,制造工艺先进;拥有严格的质量管理体系,产品质量稳定可靠

13328068681

13328068681